Przyszłość rynku AI?

Konkurowanie wartościami

[konferencja Etyka sztucznej inteligencji:

od zasad

do praktyki]

Maciej Chojnowski

Sztuczna inteligencja to nie pojedyncza technologia, ale zmienny ekosystem obejmujący organizacje, sektory i całe społeczeństwa. Dlatego etyczny rozwój AI wymaga zintegrowanych działań i współpracy. To jednak opłacalny wysiłek, bo stawką w grze jest zaufanie konsumentów.

Do kwietnia 2020 r. na całym świecie powstało ponad 170 zbiorów zasad dotyczących etycznego rozwoju sztucznej inteligencji opracowanych przez rządy, firmy czy organizacje trzeciego sektora. Jednak dokumenty te rzadko wskazują, jak przełożyć ogólne wytyczne na konkretne działania. Podczas zorganizowanej 16 listopada przez Centrum Etyki Technologii Instytutu Humanites konferencji online „Etyka sztucznej inteligencji: od zasad do praktyki. Skuteczny rozwój i wdrażanie godnej zaufania AI” międzynarodowe grono ekspertów omówiło najważniejsze kwestie związane z wdrażaniem trustworthy AI. Było to pierwsze w Polsce wydarzenie poświęcone tematyce implementacji etyki sztucznej inteligencji.

Etyka AI musi uwzględniać wiele wymiarów oddziaływania technologii na rzeczywistość społeczną, w tym m.in. na rynek pracy. Błędem jest przekonanie, że technologie i ludzie są ze sobą w konflikcie, a automatyzacja ma zastąpić człowieka. Nowe technologie mają za zadanie ułatwić pracę ludziom przez optymalizację procesów, a nie ich zastąpić. Jednak bardzo trudno będzie przekwalifikować tych pracowników, którzy są blisko końca swojej kariery. Należy więc wypracować takie rozwiązania, które nie pominą ich w nowej rzeczywistości – mówi Beata Staszków, prezes Zarządu Związku Pracodawców Polska Miedź, partnera konferencji.

Etyka albo dystopia

Sto lat temu rozwój motoryzacji wymusił na nas stworzenie zasad ruchu drogowego. Dziś potrzebujemy wypracować mechanizmy odpowiedzialnego używania sztucznej inteligencji – mówiła podczas otwarcia konferencji Zofia Dzik, prezes Instytutu Humanites i przewodniczącą Rady Programowej CET. Zasady etycznej AI już mamy. Czas sprawić, by zaczęły być wcielane w życie – wyjaśniała, podkreślając, że ambicją CET jako think&do tanku jest aktywne działanie na rzecz realizacji wymogów trustworthy AI w praktyce.

Kwestia etyki jest dziś kluczowa dla rozwoju sztucznej inteligencji i zależy od niej, czy za kilka dekad przeniesiemy się w świetlaną przyszłość, czy raczej cofniemy do 1984 roku – przekonywał Antoni Rytel, wicedyrektor Centrum GovTech. Rozwój AI, dotychczas kojarzonej z inżynierią i naukami ścisłymi, wymaga dziś wsparcia ze strony humanistyki. Dotyczy to zarówno tworzenia systemów sztucznej inteligencji, jak i edukacji nowych pokoleń. Inicjatywy podejmowane przez CET są tutaj bardzo pożądane – podkreślał.

Ekosystem, nie technologia

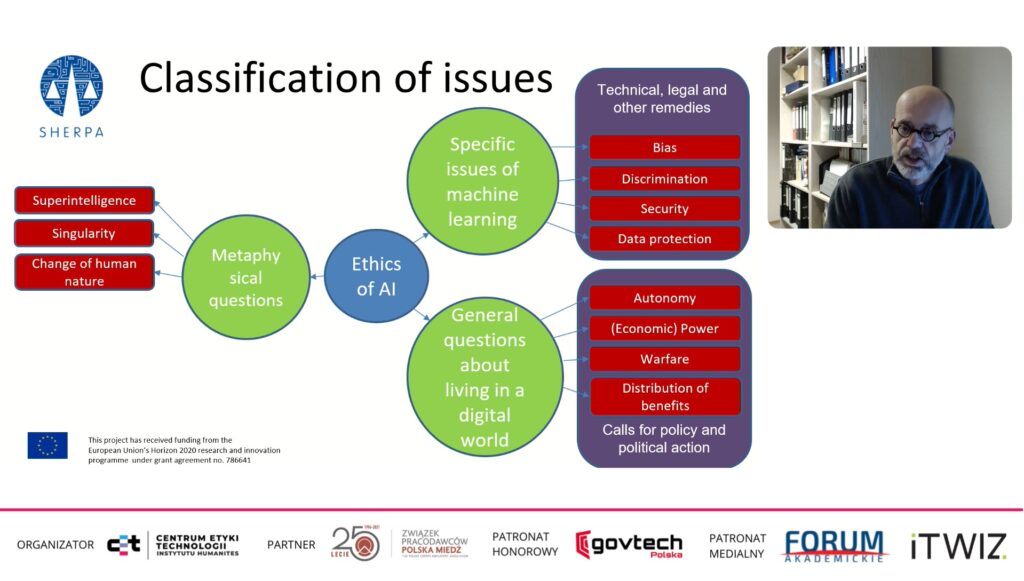

Jako keynote speaker na konferencji wystąpił prof. Bernd Carsten Stahl – dyrektor Centre for Computing and Social Responsibility na Uniwersytecie De Montfort, a także koordynator unijnego projektu SHERPA (Shaping the ethical dimensions of information technologies – a European perspective) oraz dyrektor ds. etyki we flagowym projekcie UE Human Brain Project.

Prof. Stahl omówił różne rodzaje systemów sztucznej inteligencji i związane z nimi odrębne etyczne wyzwania. Zwracał uwagę na to, że z wielością problemów etycznych idą w parze liczne możliwe rozwiązania, a także szerokie grono interesariuszy, którzy mogą przeciwdziałać negatywnym skutkom AI. Dlatego nie powinniśmy traktować sztucznej inteligencji jako pojedynczej technologii, ale raczej jako złożony i stale ewoluujący ekosystem, który wchodzi w różne interakcje ze społeczeństwem i innymi technologiami – przekonywał.

UE wspiera Ethics by Design

Takie rozumienie AI jest zdaniem Stahla bardziej praktyczne, ponieważ pozwala lepiej orientować się w istniejących problemach oraz narzędziach do ich rozwiązywania pochodzących z różnych obszarów – technicznych, etycznych, regulacyjnych czy organizacyjnych. Co istotne, umożliwia także bardziej efektywne działania w przyszłości, której wyzwania nie są nam jeszcze znane. Realizacja etyki AI to bowiem nie jednorazowe przedsięwzięcie – zaznaczał – ale regularnie ponawiany proces, które trzeba też cyklicznie poddawać ewaluacji.

Prof. Stahl przedstawił też metodę Ethics by Design wypracowaną w projektach SHERPA i SIENNA, która umożliwia zmapowanie wymogów etycznej AI z konkretnymi etapami procesu projektowania i wdrażania technologii. Jak podkreślił, stosowanie tego podejścia będzie wymagane od podmiotów chcących pozyskać granty na projekty związane z AI z unijnego programu Horyzont Europa.

Polski wkład w trustworthy AI

Unijny projekt prawa sztucznej inteligencji zachęca firmy i organizacje branżowe, by tworzyły kodeksy postępowania dotyczące systemów AI nieobarczonych wysokim ryzkiem – mówił dr Robert Sroka z Abris Capital Partners i członek Rady Programowej CET. Jednak ani w projekcie AI Act, ani w innych opracowaniach nie ma wskazówek, jak mogłoby wyglądać skuteczne wdrażanie takich dobrowolnych kodeksów. Można próbować to robić np. poprzez kodeksy zamówień publicznych i tworzenie wymagań dla dostawców AI, ale nie będą to działania wystarczające – przekonywał.

Do zaistnienia efektywnej samoregulacji potrzebne jest jego zdaniem zaangażowanie organizacji zrzeszających przedsiębiorców, które będą skutecznie promowały etykę AI oraz pomagały wdrażać jej zasady w różnych branżach i z uwzględnieniem specyfiki różnych systemów AI. Sroka zwracał przy tym uwagę, że wypracowanie nad Wisłą skutecznego mechanizmu działania w tym obszarze może być ważnym wkładem Polski w rozwój etyki AI w Europie.

Rząd nie musi stać z boku

Co ważne, organizacje branżowe nie muszą działać same. Możliwy jest scenariusz, w którym zyskują one wsparcie od krajowego organu nadzorczego nad AI i wspólnie wypracowują mechanizm regulacji. Powinna je do tego zachęcać administracja rządowa, ale także sami przedsiębiorcy. Samoregulacja bądź współregulacja to bowiem bardziej efektywne mechanizmy zarządzania niż odgórna legislacja, która często nie nadąża za zmianami na rynku technologii oraz może prowadzić do przeregulowania sektorów. Aby jednak taka współpraca mogła zaistnieć, organizacje branżowe muszą dowieść swojej wiarygodności poprzez transparentność, otwartość na dialog i troskę o dobro wspólne.

Zdaniem Roberta Sroki takie organizacje jak CET mogą odegrać ważną rolę w rozwoju trustworthy AI. W przypadku etyki sztucznej inteligencji nie mamy bowiem czasu na powolne budowanie branżowego etosu, jak miało to miejsce na przykład z zawodami lekarza czy prawnika. Dziś potrzebne są solidne ramy organizacyjne, aby sprawnie wypracować skuteczne mechanizmy realizacji etyki AI w różnych sektorach.

O tym, że skuteczne działania polskich organizacji branżowych są w tym obszarze możliwe, świadczy świeżo opublikowany przez Izbę Gospodarki Elektronicznej „Kodeks etyki e-commerce”. Dokument, opracowany przez dr Roberta Srokę, przedstawił podczas konferencji Paweł Oksanowicz – szef Grupy Merytorycznej Zrównoważony Biznes i CSR w e-Izbie.

Etyki nie zalgorytmizujesz

Z kolei na problem z przekładaniem na praktykę ogólnych zasad czy wymogów godnej zaufania AI zwracali uwagę dr Michał Nowakowski i Mateusz Chrobok z firmy Ceforai. Realizacja dobrostanu społecznego czy środowiskowego jest na tyle ogólnym wskazaniem, że może stanowić wyzwanie przy próbie jej skonkretyzowania. Dlatego wytyczne dot. trustworthy AI wymagają doprecyzowania, by można je było skutecznie wdrożyć – przekonywał dr Nowakowski. Mateusz Chrobok zwracał też uwagę, że nieprecyzyjność niektórych szczegółowych pojęć (np. krzywdy) sprawia, że trudno jest je przełożyć na konkretne rozwiązania programistyczne.

Przedstawiciele Ceforai zauważali zarazem, że rzeczywistość nie jest zero-jedynkowa i pomysł na rozwiązywanie problemów etyki AI przez ich algorytmizację jest skazany na niepowodzenie. Należy raczej myśleć o odpowiednim włączeniu etyki do procesu rozwoju oprogramowania.

Bardzo ważne jest przy tym traktowanie zagadnień etycznych związanych z systemami AI jako wyzwań dotyczących całych organizacji, a nie wyłącznie programistów. Decyzje związane z odpowiedzialnym projektowaniem AI przekładają się bowiem na realizację celów przyjętych przez firmy. W tej sytuacji kluczowego znaczenia nabiera odpowiednia komunikacja oraz umiejętność uzgadniania priorytetów biznesowych z wymogami etycznymi oraz właściwe przełożenie ich na rozwiązania zapisane w kodzie.

Zaufanie jako przewaga konkurencyjna

W przyszłości będziemy konkurować o zaufanie i wartości – mówiła dr Anna Topol, Chief Technology Officer w IBM Research, przywołując słowa Arvinda Krishny, dyrektora generalnego IBM. Pozyskanie zaufania do sztucznej inteligencji to złożone wyzwanie społeczno-technologiczne – podkreśliła. Próbujemy zrozumieć dalekosiężne konsekwencje AI, jednak wyzwania, z którymi musimy się mierzyć, w niektórych wypadkach nie są nawet jeszcze dobrze zdefiniowane. Dlatego etyka musi być zawarta w procesach projektowania i wytwarzania AI od samego początku. Co więcej, wypracowane rozwiązania powinny być też skalowalne.

Dr Topol zaznaczyła, że za wpływ AI na świat odpowiadają zarówno pojedyncze osoby zaangażowane w ich budowę, jak i firmy, które inwestują w rozwój takich systemów. Dlatego bardzo ważna jest zintegrowana strategia etyki AI obejmującą całą organizację.

Wycena według wartości (moralnych)

W IBM oprócz powołania Rady ds. Etyki stworzono program edukacyjny dla wszystkich pracowników, a także uruchomiono program badawczy do prac nad odpowiedzialnym rozwojem AI zgodnie z wartościami przyjętymi przez firmę. Ponadto IBM regularnie uczestniczy w międzysektorowych, rządowych i naukowych projektach dotyczących AI i etyki, a także organizuje spotkania z różnymi interesariuszami.

Firma korzysta również z badań prowadzonych przez IBM Institute for Business Value, który dostarcza informacji na temat postaw konsumentów i liderów. W 2020 r. aż 81 procent ankietowanych konsumentów stwierdziło, że ich niepokój wobec sposobu, w jaki firmy używają ich danych, wzrósł w ciągu ostatnich 12 miesięcy. To bardzo trudna sytuacja dla firm chcących rozwijać nowe technologie – mówiła dr Topol. Dziś wycena organizacji zależy od przyjętych przez nią wartości – podkreślała, raz jeszcze przywołując słowa Arvinda Krishny.

W tradycji Humanites

W podsumowaniu konferencji Maciej Chojnowski, dyrektor programowy CET, zwracał uwagę na potrzebę uzgadniania wymogów etyki sztucznej inteligencji ze wszystkimi działaniami organizacji. Wdrożenie odpowiedzialnej AI wymaga całościowego spojrzenia – mówił. Etyka AI to nadal etyka ludzi: inżynierów, menedżerów, ale i użytkowników. Wszyscy jesteśmy za nią w jakimś stopniu odpowiedzialni. CET promując systemowe podejście do etyki AI może w tym zakresie nawiązywać do dorobku Instytutu Humanites, którego jest częścią – dodawał. To bowiem tutaj od ponad 10 lat rozwijana jest koncepcja zintegrowanego przywództwa.

Konferencja „Etyka sztucznej inteligencji: od zasad do praktyki” odbyła się pod honorowym patronatem Centrum GovTech. Partnerem wydarzenia był Związek Pracodawców Polska Miedź, a patronatem medialnym objęły je „Forum Akademickie” oraz „ITWiz”.